TensorFlow基本上成为了深度学习的标配。但是为了学习主要的内容(忽略底层实现细节)或者快速实现一个神经网络模型,Keras是一个很好的选择。

环境准备

安装步骤

安装R的Keras需要用到devtools::install_github()命令,因此需要安装devtools包。

但是笔者用的Windows 10,直接安装包不会报错,但是使用该包下的命令会出一些奇怪的错误,例如在装R-Keras时就报超时。

所以建议在Windows下使用该包时,先去安装Rtools。

同时需要安装好Anaconda,不然在后续步骤中会报错。

安装好Rtools之后,打开R命令行,在其中再安装一遍devtools包:

1 | install.packages("devtools") |

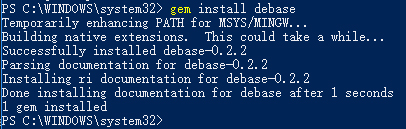

然后安装R的Keras接口:

1 | devtools::install_github("rstudio/keras") |

在命令行或者第一次运行Keras的脚本下输入:

1 | library(keras) |

然后会调用Anaconda为R-Keras建立一个环境,成功初始化,在以后的R脚本就不需要再使用install_keras()命令了。

安装GPU支持

事实上这部分操作是属于Anaconda那边的操作,毕竟R-Keras用的还是Python的TensorFlow后端。

中文文档里面就已经很详细地介绍了如何准备GPU环境:

文档写的时候上述Keras尚未支持高版本的CUDA和cuDNN,经笔者测试,是可以支持最新版的CUDA和cuDNN的。

安装好后,打开Anaconda Navigator管理软件,或者命令行模式:

1 | $ activate r-tensorflow |

切换到r-tensorflow环境,安装gpu版Keras:

1 | $ conda install keras-gpu |

等待安装过程(可能因为墙导致下载出问题,要么上梯子,要么辛苦一点重试几次安装命令吧)后,就可以开始使用了。

测试R-Keras

官网给了MNIST测试集作为Demo,然而AWS被墙了,整个Demo直接卡在下载数据集步骤就挂了。

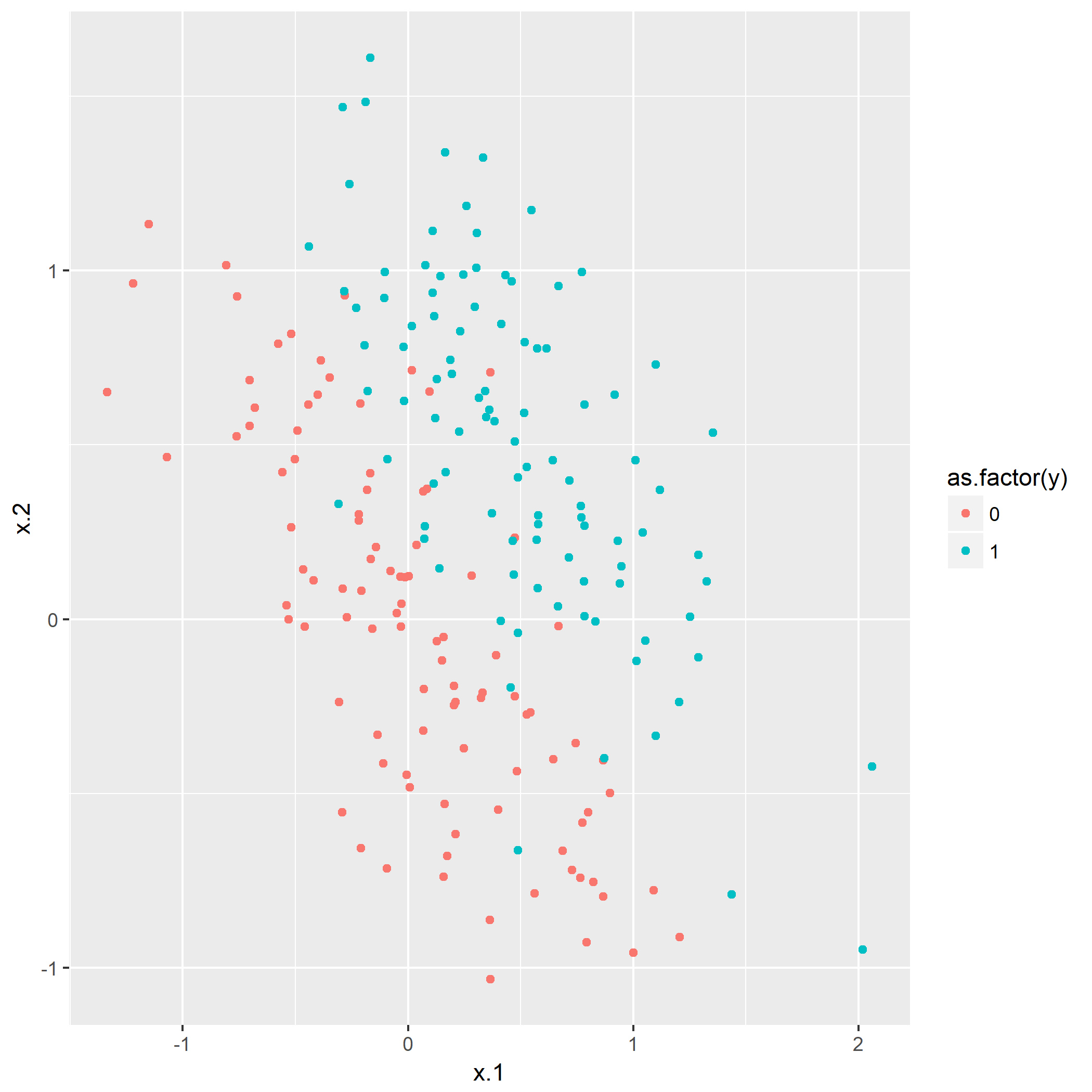

笔者写了个简单的脚本用于测试:

1 | library(keras) |

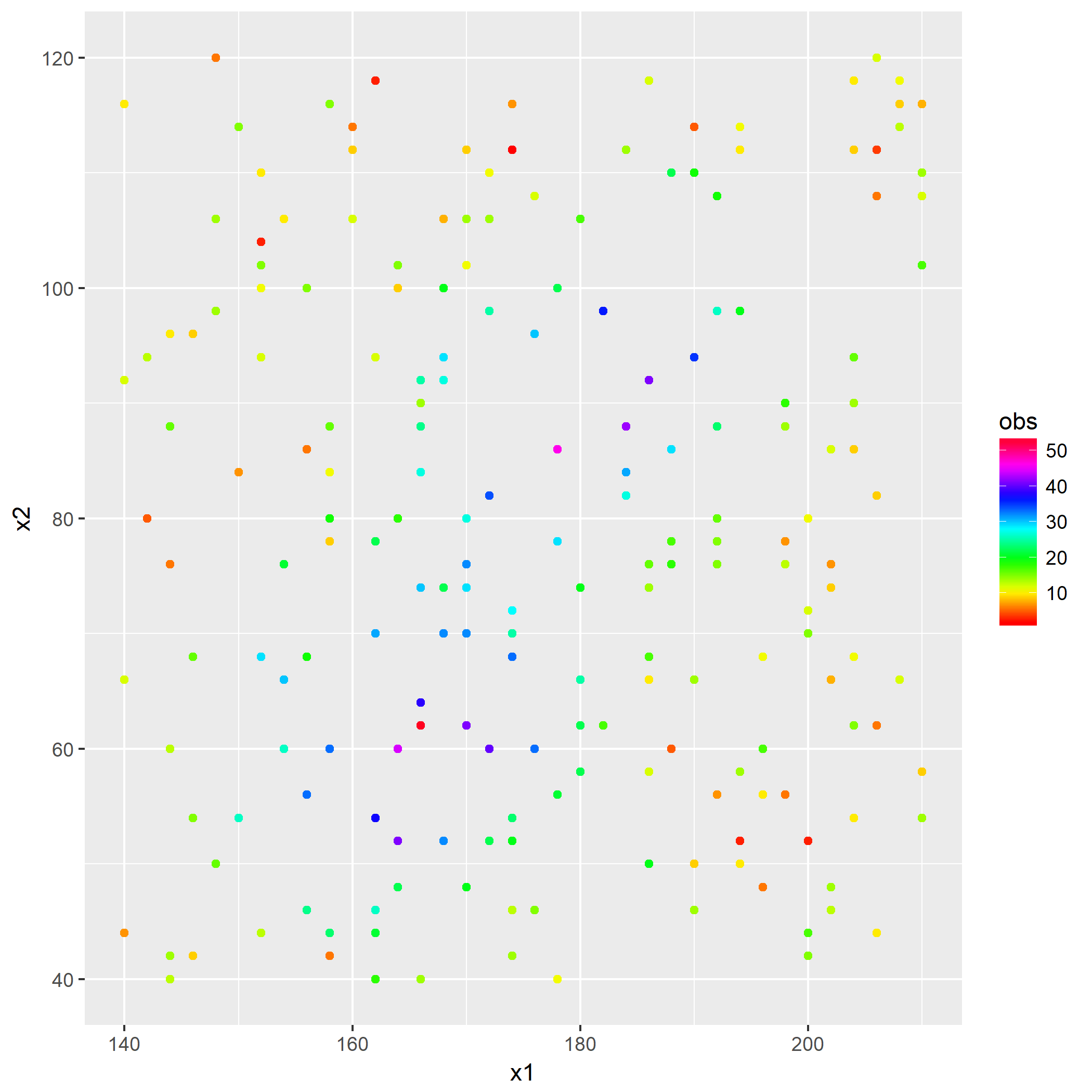

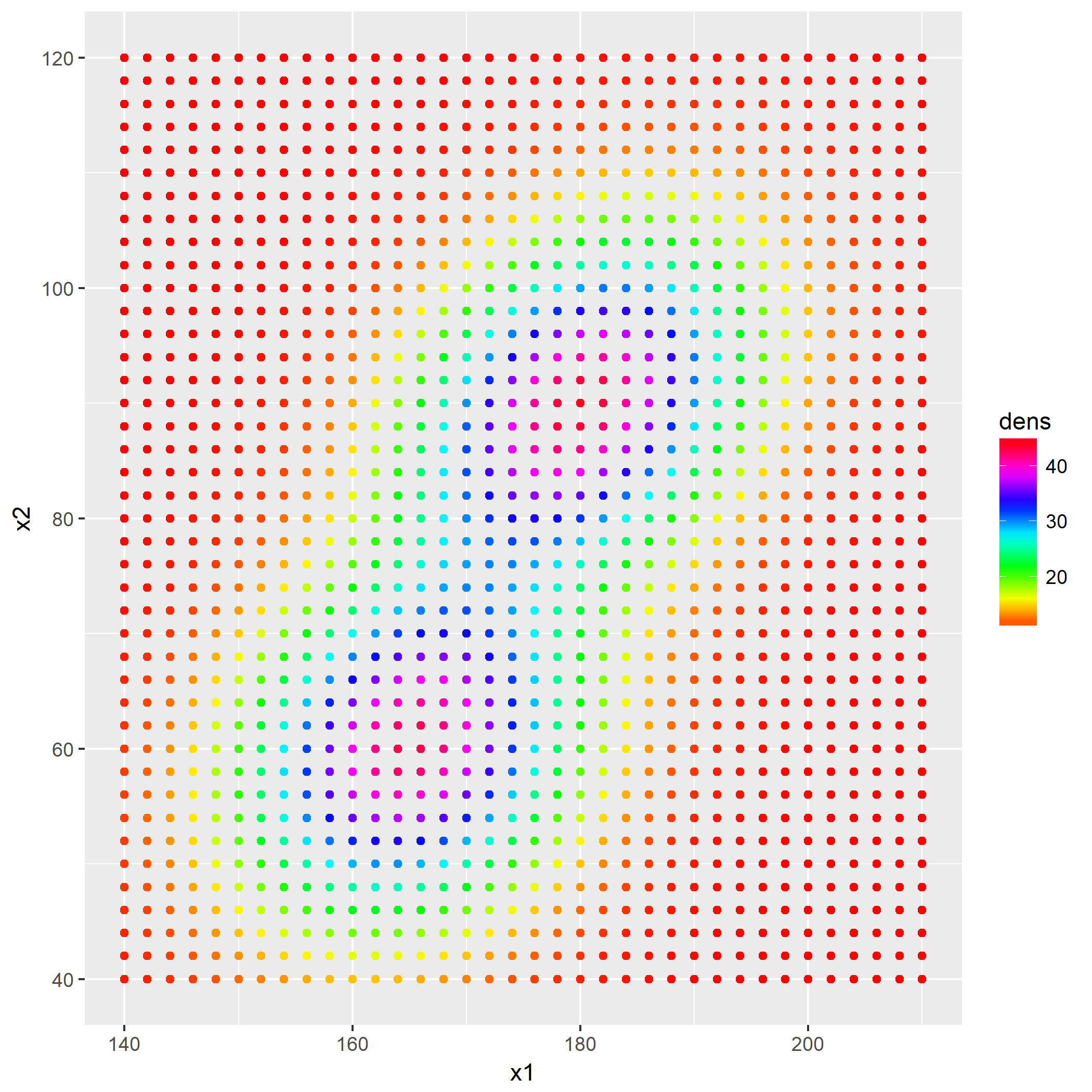

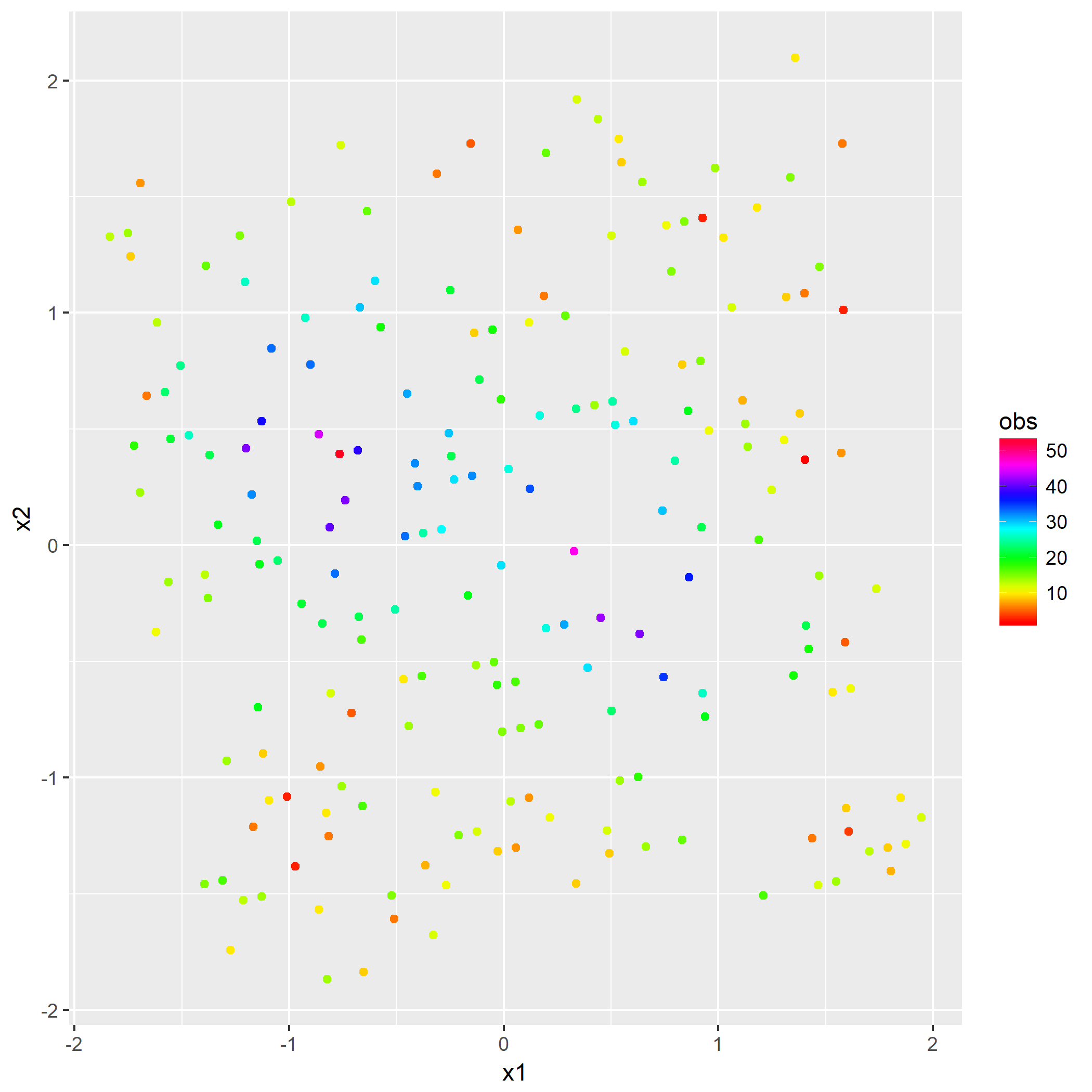

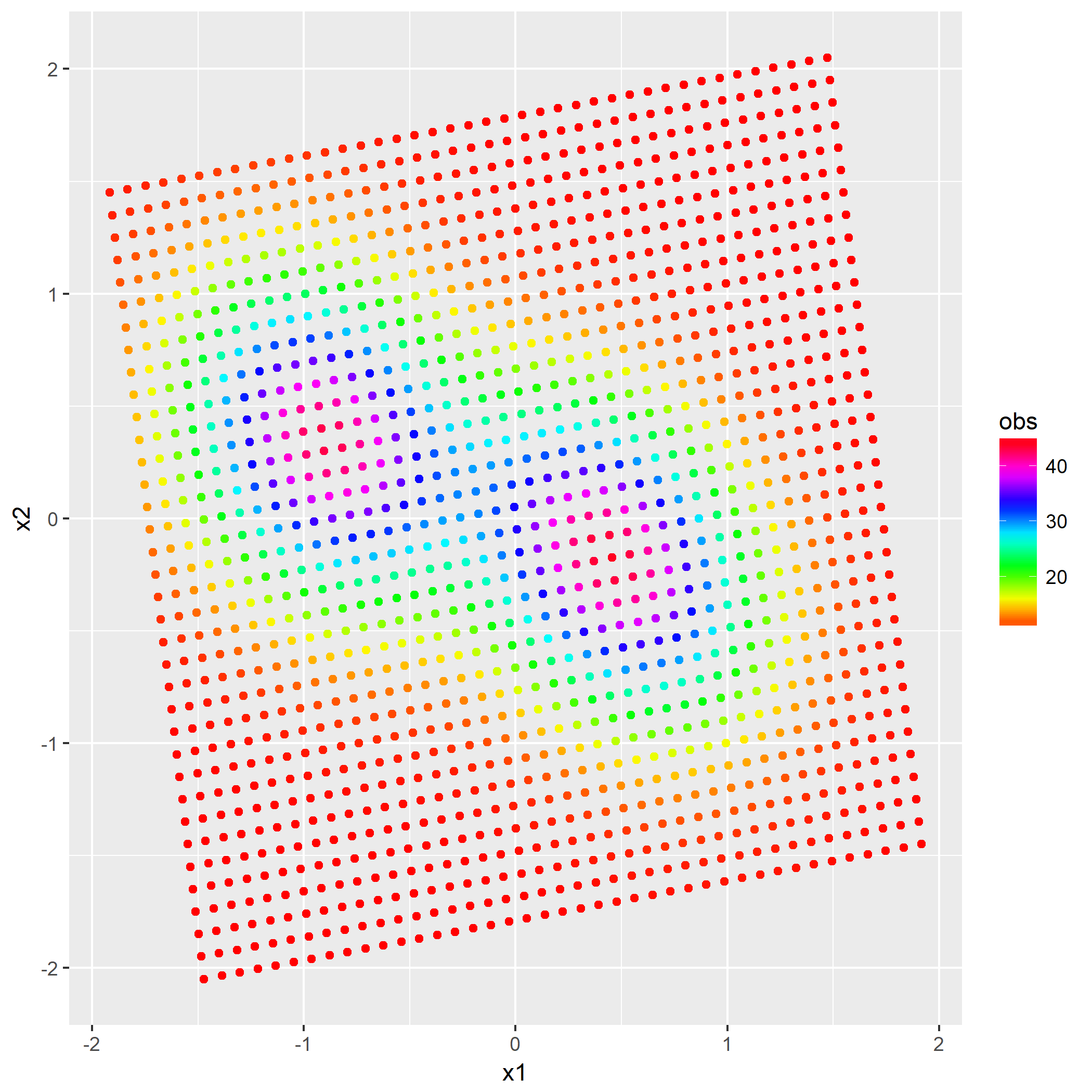

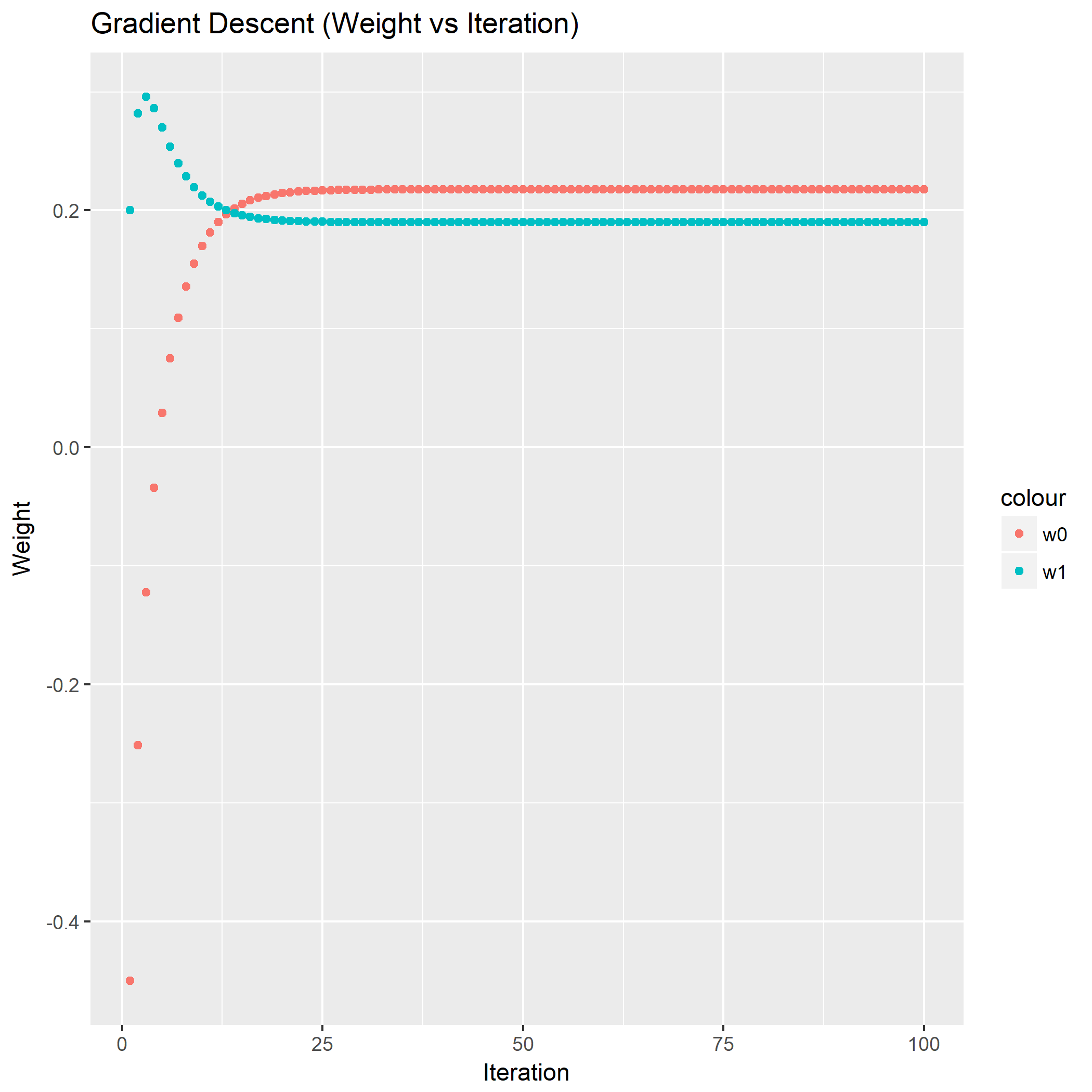

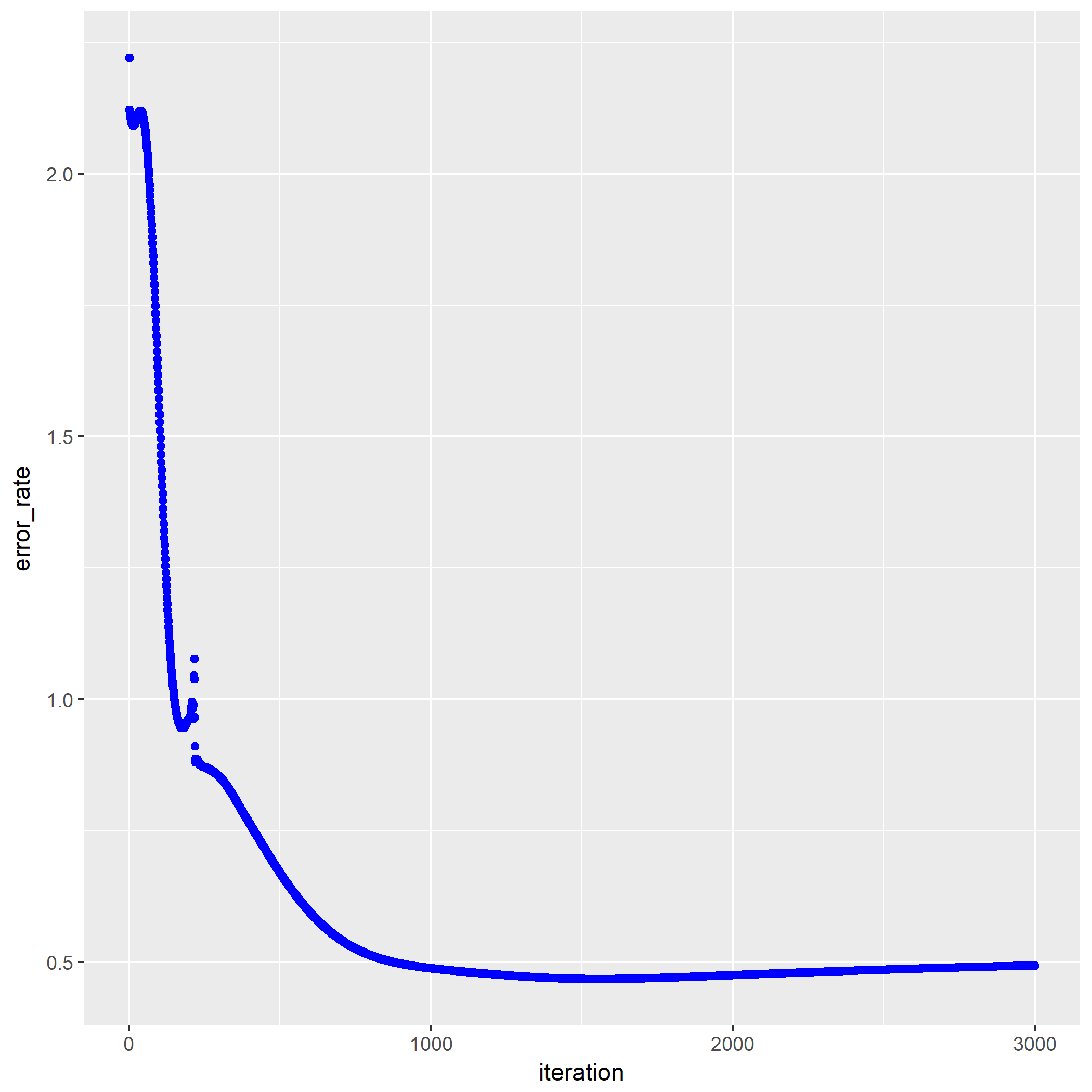

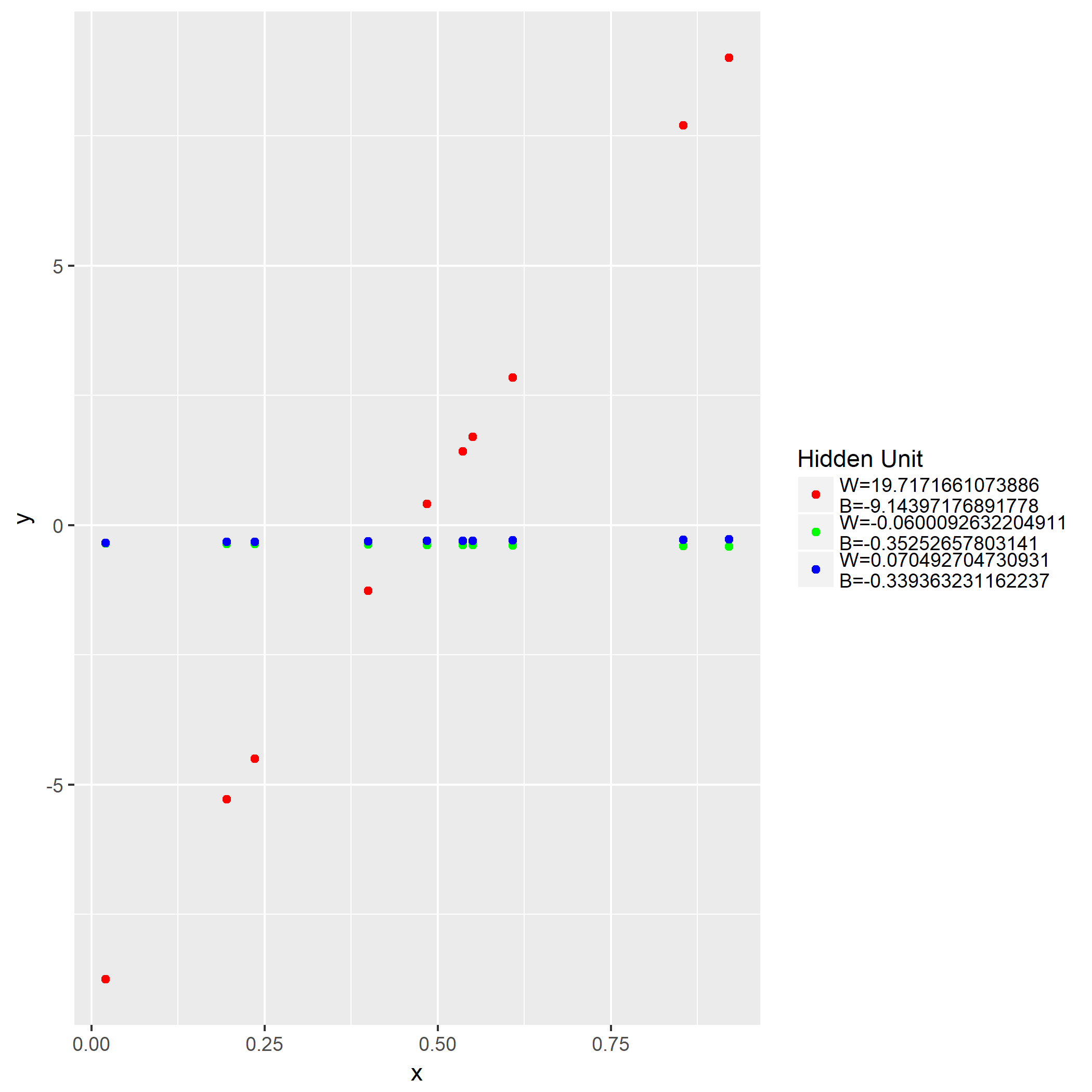

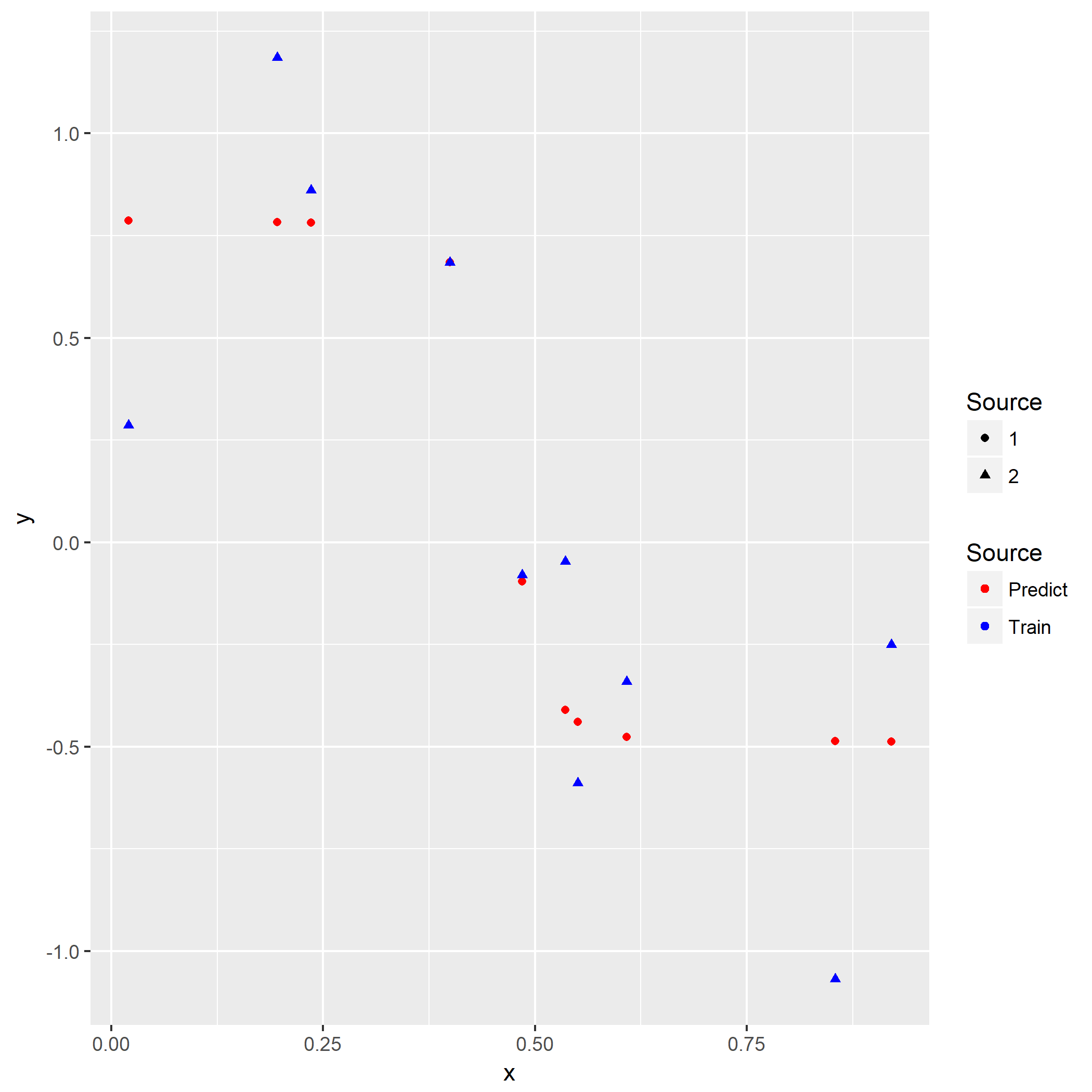

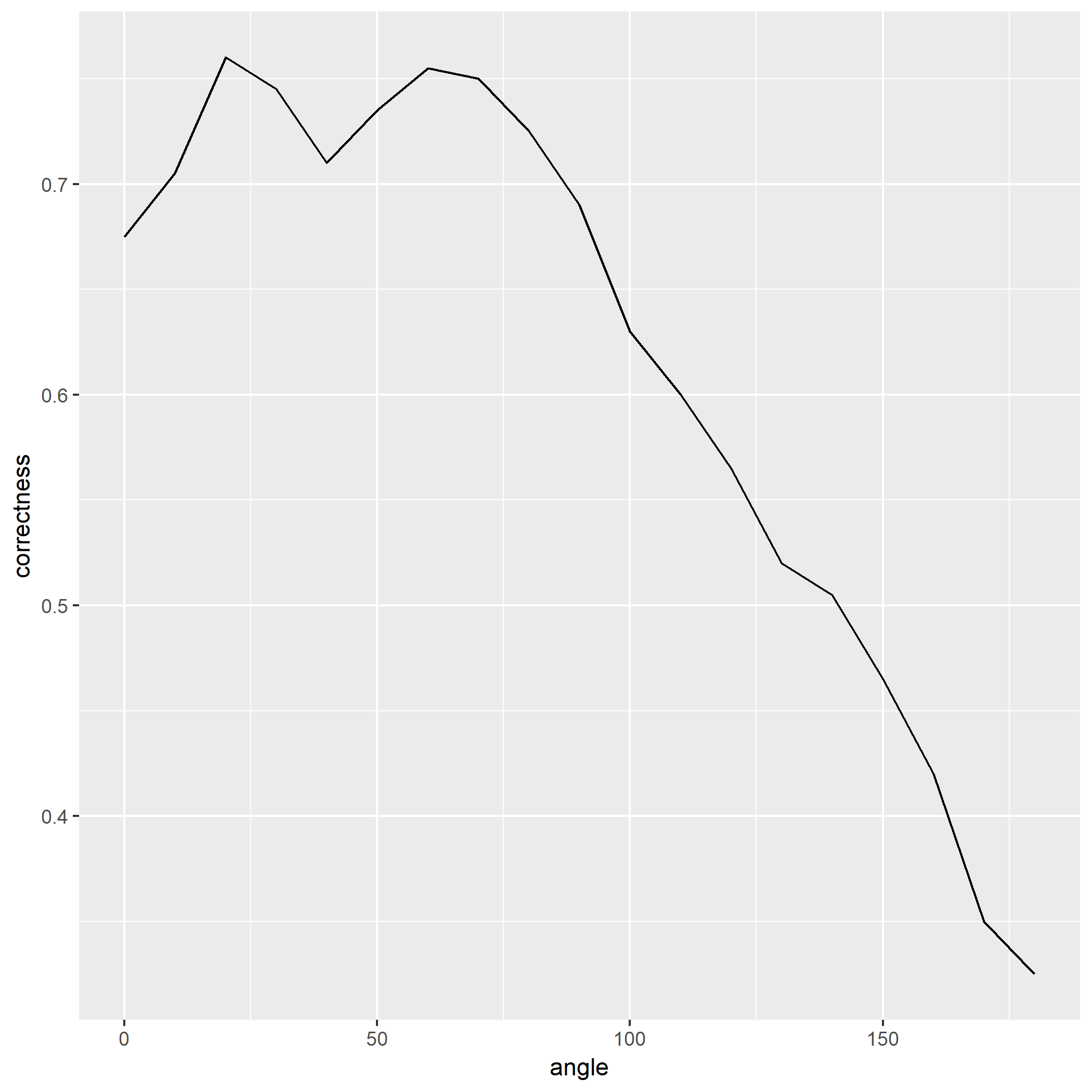

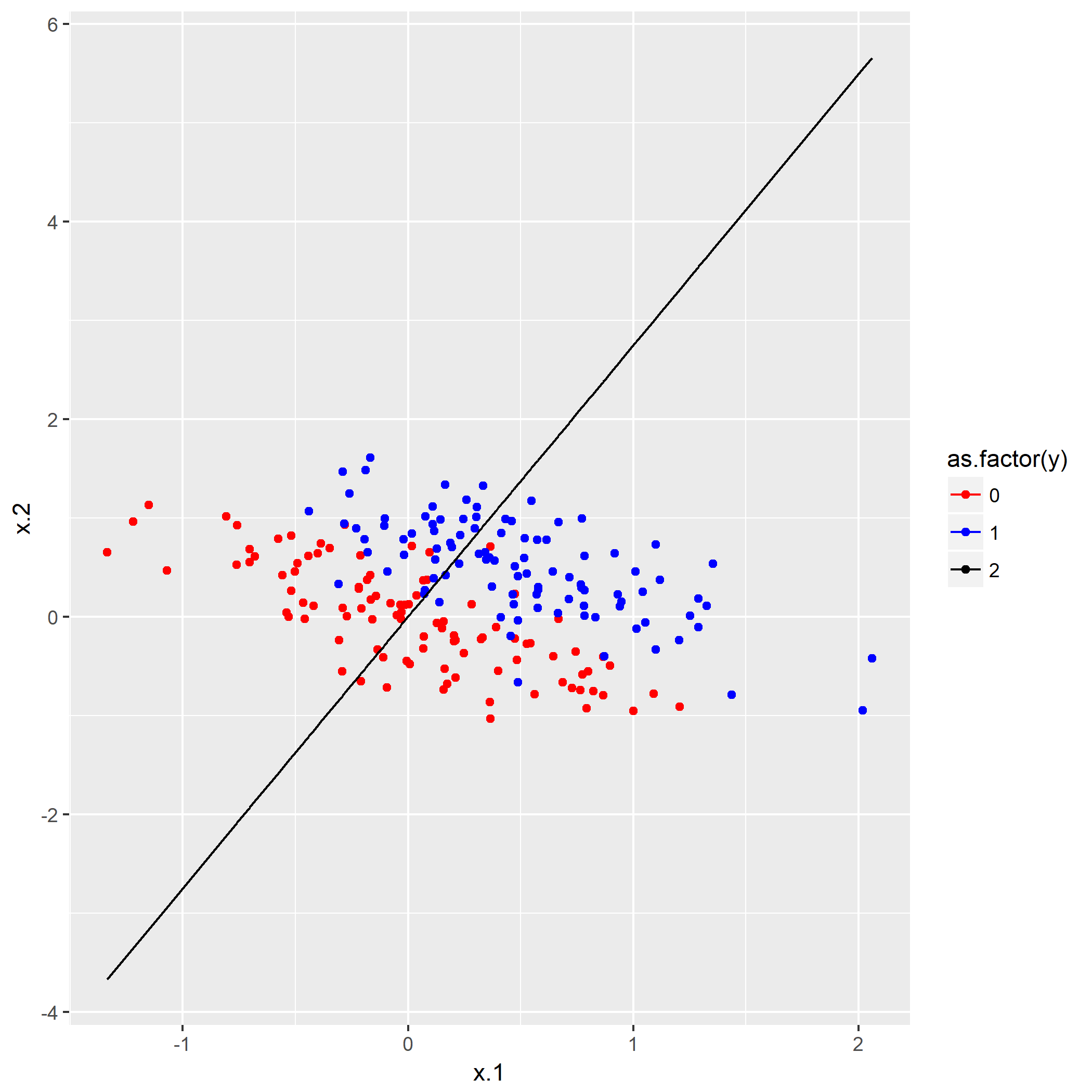

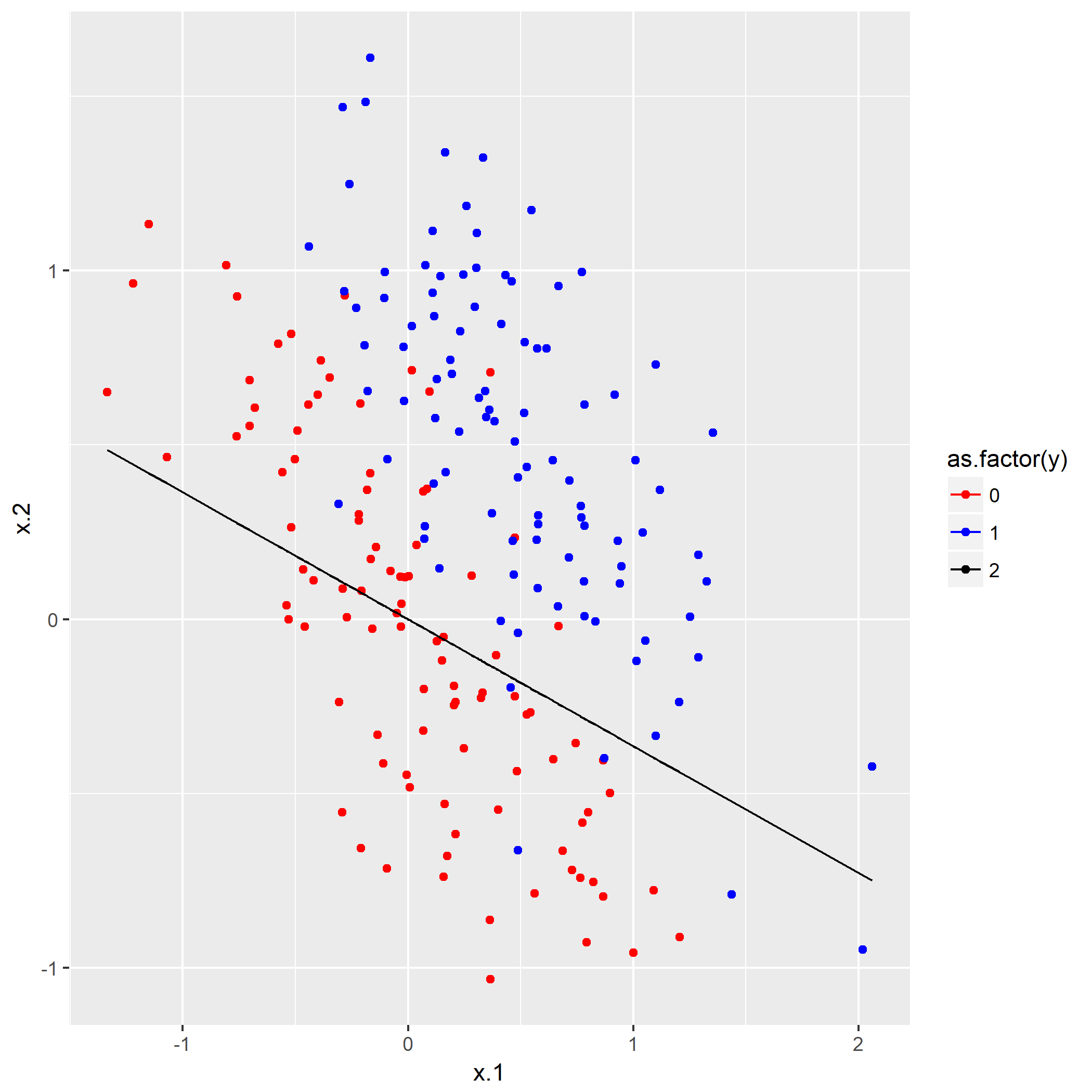

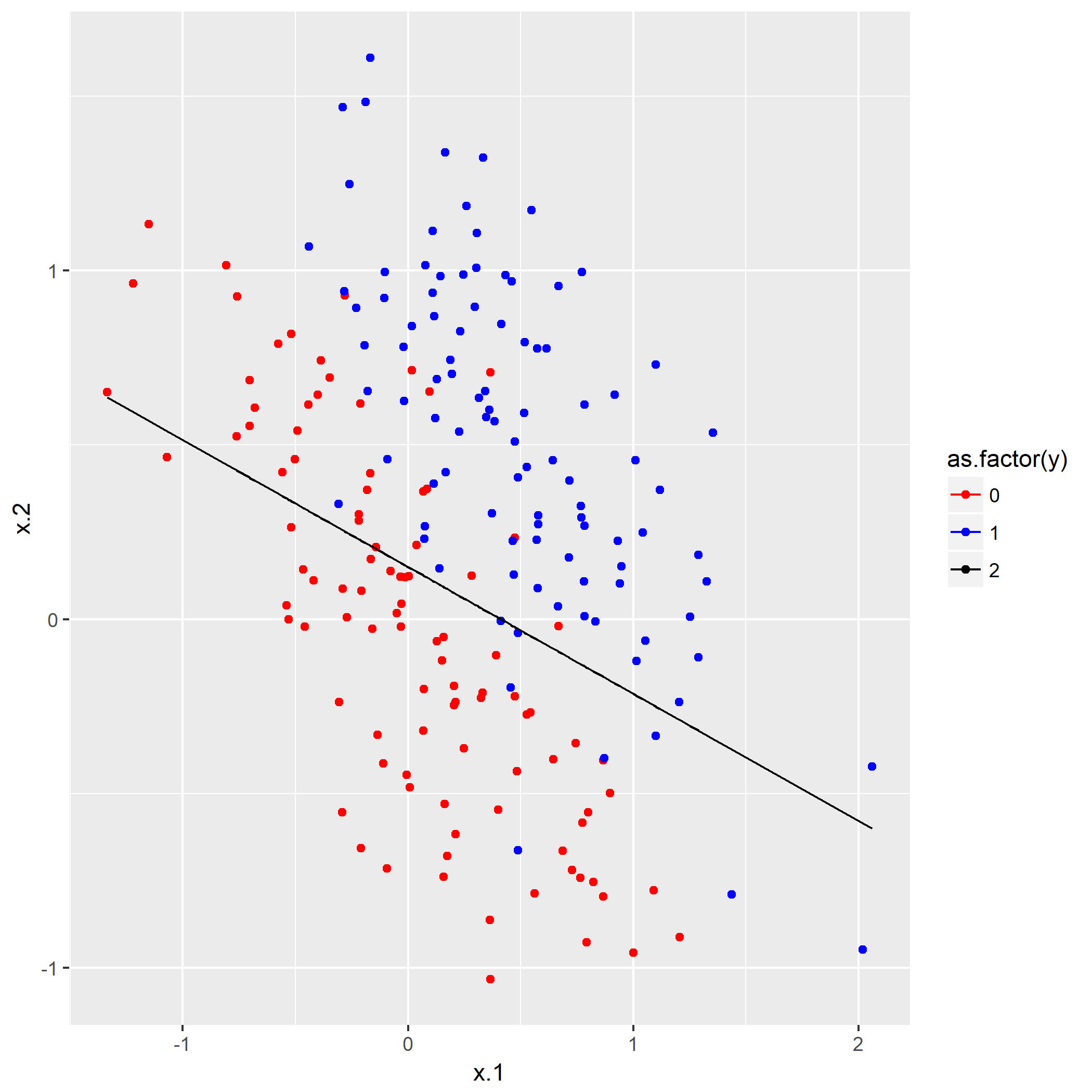

如果脚本成功运行的话,会在相同目录下产生一份名为history.png的图片,那么恭喜,安装成功了。